Generative KI-Fähigkeiten erweitert: Kernbegriffe

Large Language Models (LLM), Retrieval-Augmented Generation (RAG), Knowledge Graphs (KG)

Hier versuchen wir, eine nicht-technische Einführung in Basiskonzepte hinter unserer Knowlege-Management-App zu bieten.

Sollten Sie technisches Verständnis vertiefen wollen, folgen Sie die Links oder kontaktieren Sie uns für einen Workshop.

>>>

GenKI / GenAI = Generative künstliche Intelligenz / Generative artificial intelligence.

RAG = Retrieval-Augmented Generation (Generierung von Antworten gestützt vom Abruf von relevanten Daten).

LLM = Large Language Model (Sprachmodell).

KG = Knowledge Graph / Wissensgraph.

Unter "LLM-basierte App" versteht man eine App, die im Hintergrund ein Sprachmodell (Large Language Model, LLM) hat.

Eine LLM-basierte App wird hier als Oberbegriff bzw. ein Beispiel benutzt.

Die vorgestellten Konzepte können auf weitere GenKI-basierte Apps übertragen werden.

>>>

Generative KI (1/2)

basiert sich auf existierenden Ressourcen

Generative KI sind die Modellen der maschinellen Lernens, das Deep Learning, die basierend auf gelernten Mustern neue Texte, numerische Datensätze, Bilder, Audio oder Videos erschaffen können. Die Deep-Learning-Modelle, benannt als künstliche neuronale Netze, imitieren die Funktionierung des menschlichen Gehirns. Die von denen neu kreierten Inhalte sind den von den Menschen kreierten Inhalten ähnlich.

Rein generative KI, z.B. Sprachmodelle (Large Language Models, LLMs), sind keine Wissenstools. Sie basieren auf statistische Informationen über die Daten mit Hilfe von welchen sie trainieret wurden. Dementsprechend erschaffen sie die Texte (vervollständigen die Texte oder beantworten die Fragen) bzw. reagieren auf einen Prompt nur probabilistisch.

Ziel: GenKI setzt die Nutzung von einer natürlichen Sprache voraus, um hochrelevante Erkenntnisse zu gewinnen und Denkanstöße im eigenen Fachgebiet zu erhalten.

Mittel: Deep-Learning-Modelle wie Transformator-basierte Modelle (Transformer), Generative kontradiktorische Netze (Generative Adversarial Networks), oder Variationale Autoencoder.

Sicherheit: Die Modellen, die hinter den Tools stehen, die auf dem Markt angeboten sind (z.B. Chats), können die Daten, die in sie fließen, für weiteres Training nutzen; Output kann biased, beleidigend, fingiert, logisch inkorrekt oder ungenau sein; Nutzung der generativen KI kann Nachhaltigkeit in Frage stellen.

Mehr zu KG & RAG-LLM:

* Was ist generative künstliche Intelligenz? (Universität zu Köln, Digital Education, KI in der Bildung)

* Was ist generative KI? (SAP)

* Was ist generative KI? (IBM)

* Was ist generative KI? (AWS re:invent)

Generative KI (2/2)

in der Bearbeitung

in der Bearbeitung.

Ziel: in der Bearbeitung.

Mittel: in der Bearbeitung.

Sicherheit: in der Bearbeitung.

Mehr zu KG & RAG-LLM:

* in der Bearbeitung.

Retrieval-Augmented Generation (RAG)

Hilft, vorhandene Datenbestände zu nutzen

RAG ist ein Framework für Verbesserung der Fragenbeantwortungs-Performance, z.B. von einer LLM-basierten App, indem die Fragen (so genannte Prompts) im Hintergrund der GenKI-App mit relevanten Unternehmensdaten ergänzt und ausgeführt werden.

Ziel: RAG ermöglicht, die Antworten präziser und unternehmensspezifischer zu machen und das Risiko von Halluzinationen zu reduzieren, das durch die Nutzung von ein Sprachmodell existiert.

Mittel: ein auf dem Markt vorhandenes Sprachmodell (LLM), auch ohne Rückfluss von den Unternehmensdaten zurück in die Welt.

Sicherheit: im Cloud oder On-Premises, so dass die Daten gesichert und unter Unternehmenskontrolle bleiben.

Mehr zu RAG:

* Basic Concepts (LangChain Tutorial mit einer hilfreichen Introduktion, aktuelle Version)

* RAG from Scratch (GitHub-Code mit ausführlicher Abbildung)

* An Introduction to RAG (Chia Jeng Yang, Medium, 12/2023)

* Strings vs. Understanding: Relating Strings to Meanings (Mike Dillinger, Medium, 08/2023)

Fine-Tuning vs. RAG

Auswahl hängt von Zielen des Unternehmens ab

Einige Unternehmen zögern, die LLM-basierten App einzusetzen, weil sie "halluzinieren" können oder sich nicht auf die Wissensbasis des Unternehmens stützen. Zwei mögliche Ansätze, um diese Herausforderung zur überwinden, sind Fine-Tuning und RAG. Die Fine-Tuning setzt ein weiteres Training des Modells durch die Bereitstellung von Frage-Antwort-Paaren voraus. RAG impliziert die Bereitstellung vom Zugang zu relevanten (Unternehmens-)Daten.

Ziel: Fine-Tuning ist bei einer begrenzter Anzahl von "üblichen" Fragen hilfreich. RAG ermöglicht die Verwendung natürlicher Sprache, um die komplexeren Fragen anhand der Informationen in Ihrem Unternehmen zu beantworten, und kann effizienter bei Entscheidungsfindung helfen.

Mittel: ein auf dem Markt / open-source vorhandenes Sprachmodell (LLM), eine Datenbank.

Sicherheit: im Cloud oder On-Premises, so dass die Daten gesichert und unter Unternehmenskontrolle bleiben.

Mehr zu Fine-Tuning vs. RAG:

* Fine-Tuning & RAG (Tomaz Bratanic & Kuman Harsh, neo4j / Medium, 09/2024)

Knowledge Graph / Wissensgraph

Steht hinter Google-Suche, DBpedia oder Wikidata

Wissensgraph ist ein semantisches Netzwerk, das die Beziehungen zwischen Konzepten und Objekten, Ereignissen und Situationen, und anderen Wissenseinheiten (oder Wissensentitäten) darstellt. Wissensgraph besteht aus Knoten und Beziehungen zwischen denen. Die Beziehungen erfassen den Kontext und hervorheben die Bedeutungen von den Wissenseinheiten (Knoten).

Ziel: semantische Beziehungen zwischen Wissenseinheiten darzustellen und dadurch die Untersuchung von Ursache-Wirkungs-Zusammenhängen zu unterstützen.

Mittel: ein Tool, das die Darstellung von Knoten und Kanten als auch deren Beschriftung ermöglicht; spezialisierte Anwendungen.

Sicherheit: im Cloud oder On-Premises, so dass die Daten gesichert und unter Unternehmenskontrolle bleiben.

Mehr zu Wissensgraphs:

* Was ist ein Wissensgraph? (IBM)

* Knowledge Graphs: How do we encode knowledge...? (The Alan Turing Institute)

* What is a Knowledge Graph? (ontotext: a graphwise company)

* What is a Knowledge Graph? (John Stegerman, neo4j)

KG & RAG-LLM

Können die Entscheidungsfindungseffizienz erhöhen

in der Bearbeitung.

Ziel: in der Bearbeitung.

Mittel: in der Bearbeitung.

Sicherheit: in der Bearbeitung.

Mehr zu KG & RAG-LLM:

* Composite AI (Gartner, 01/2024)

* in der Bearbeitung.

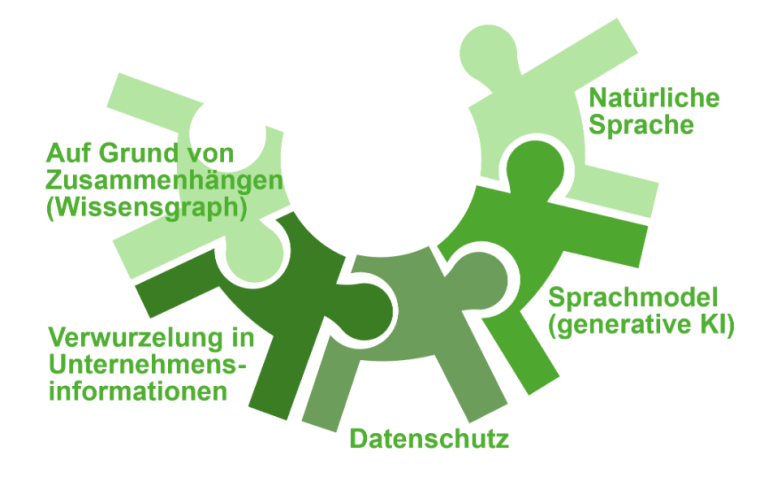

Wissensgraph

(Knowledge Graph, KG)

Darstellung von Zusammenhängen zwischen Konzepten und Ereignissen, um Transparenz und Analyse und dadurch die Entscheidungsfindung und Wissengewinnung zu fördern.

Verwurzelung in dem Unternehmenswissen

(Retrieval-Augmented Generation, RAG)

Daten aus verschiedenen Unternehmenskommunikations- und Kollaborationssystemen und aus Dokumenten in verschiedenen Formaten nutzen, um Kontext zu berücksichtigen und dabei zuverlässige Quellen zu haben.

Kommunikation mit der Wissensbasis in natürlicher Sprache

Situation beschreiben, Fragen stellen und nicht nach passenden Keywords suchen, um Effizienz und Zugänglichkeit zu fördern.

Extern trainiertes Sprachmodel intern angewendet

(Large Language Model, LLM)

Die Vorteile von open-source-Modellen nutzen, ohne dass die unternehmensinterne Daten in die Welt fließen.

Daten gesichert und geschützt

Im Cloud oder im Haus (on premises), um immer die Kontrolle über die Daten zu behalten.

Wir benötigen Ihre Zustimmung zum Laden der Übersetzungen

Wir nutzen einen Drittanbieter-Service, um den Inhalt der Website zu übersetzen, der möglicherweise Daten über Ihre Aktivitäten sammelt. Bitte überprüfen Sie die Details in der Datenschutzerklärung und akzeptieren Sie den Dienst, um die Übersetzungen zu sehen.